蓝图篇 - Ollama

获取 Ollama

可以通过 Ollama 官网获取安装包本地安装:ollama.com

可以通过其他人提供的 Ollama API 接口使用 Ollama。

本地使用 Ollama 下载模型:

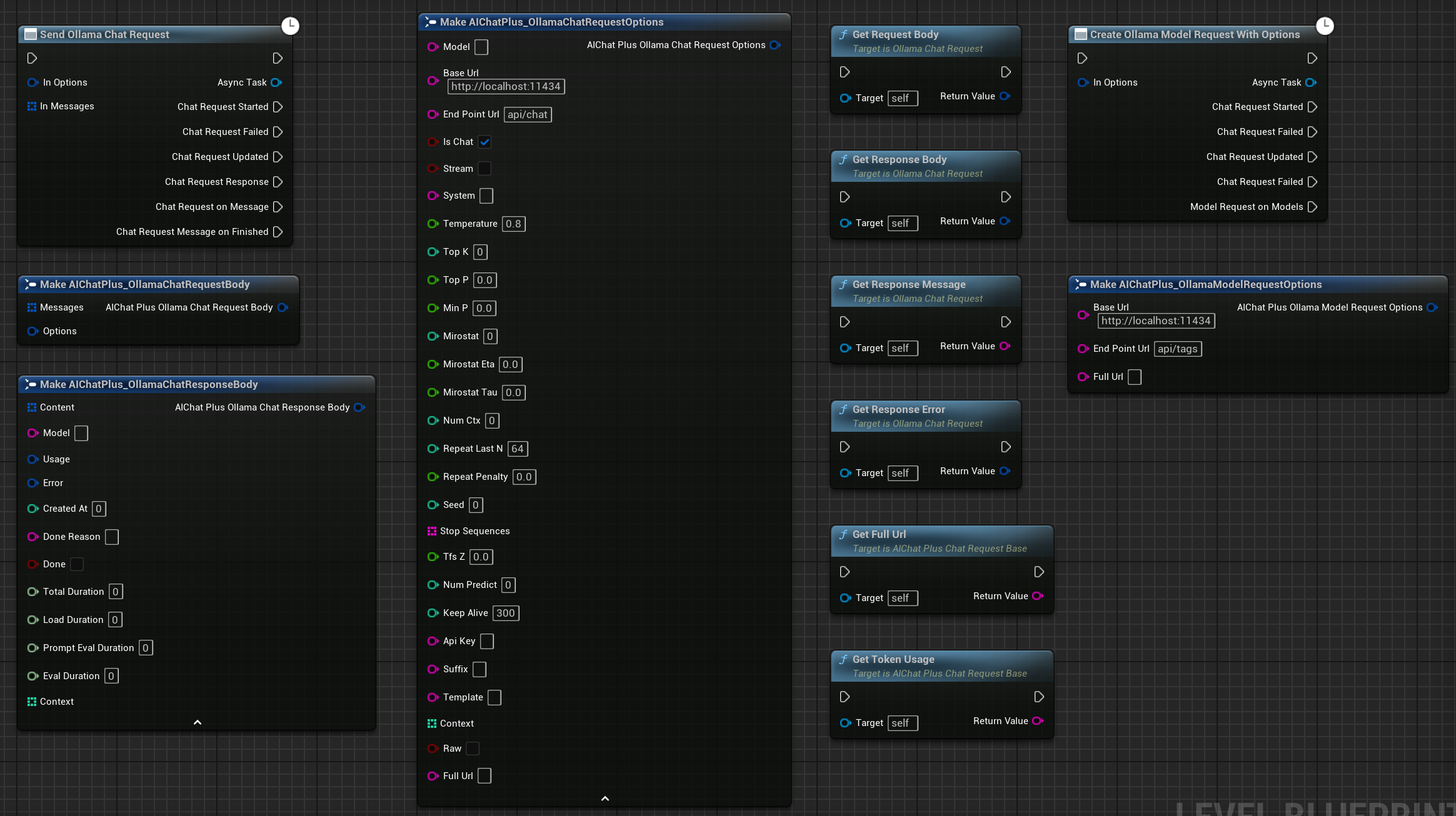

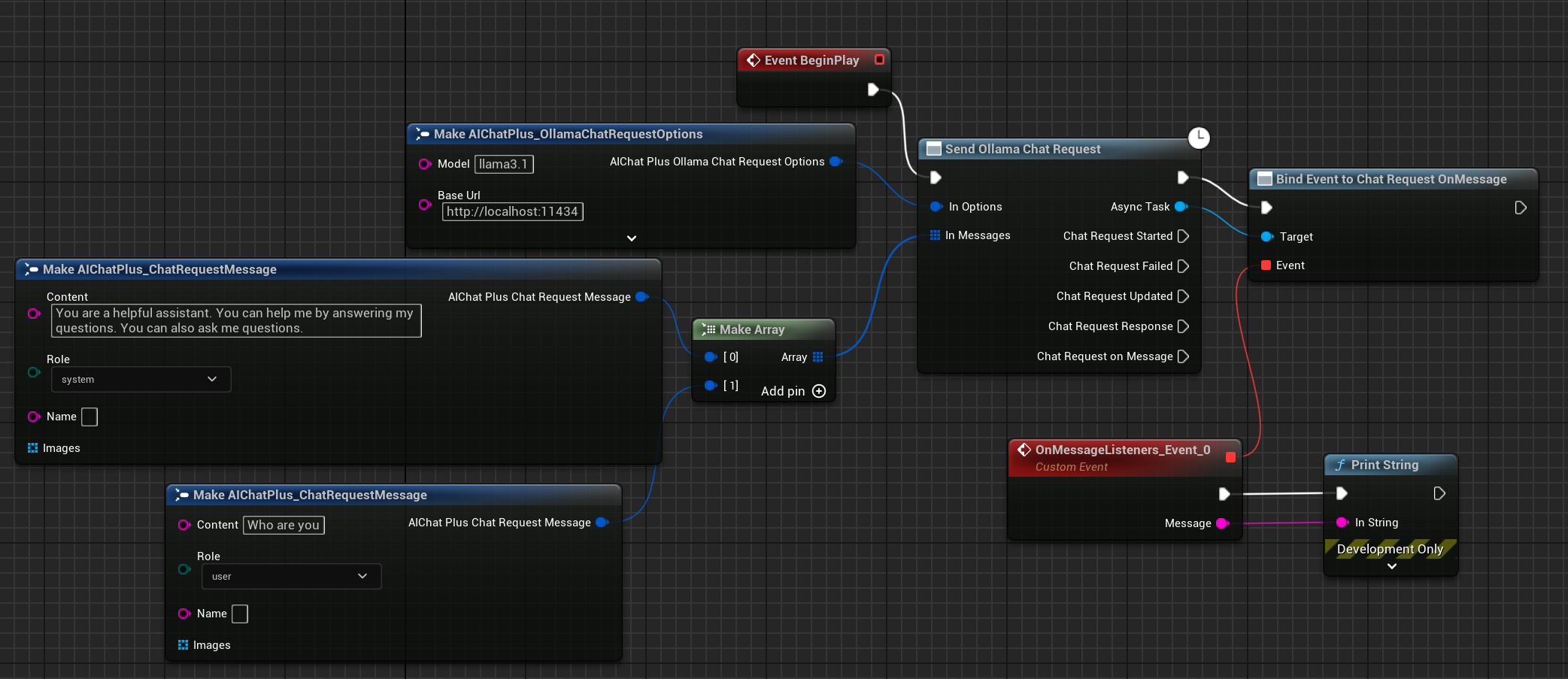

文本聊天

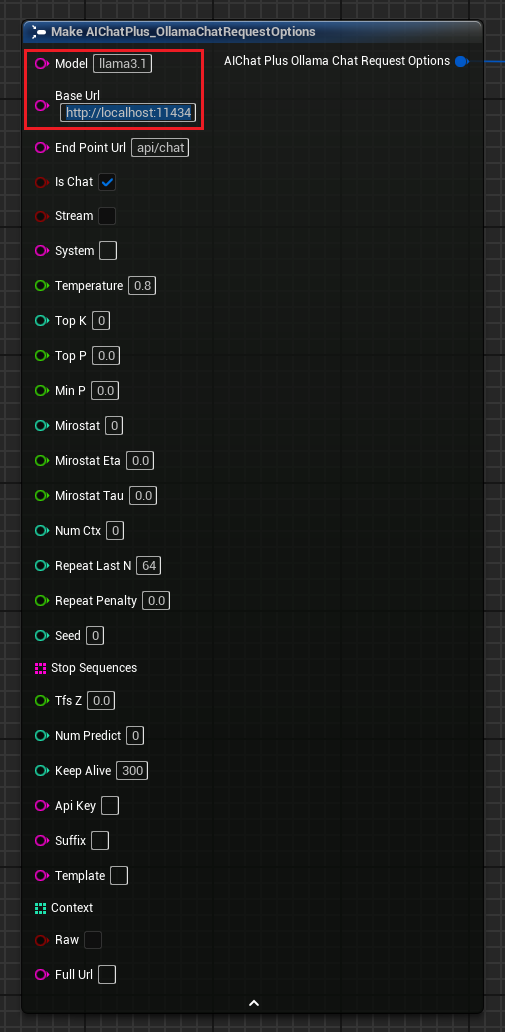

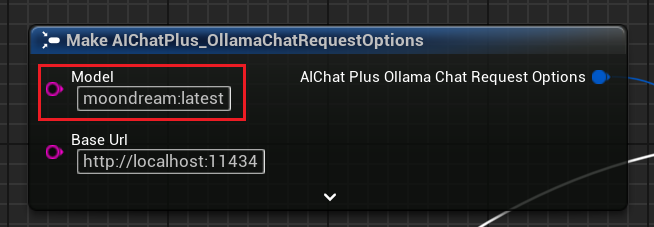

创建 "Ollama Options" 节点,设置参数 "Model", "Base Url",如果是本地运行的 Ollama,则 "Base Url" 一般是 "http://localhost:11434"

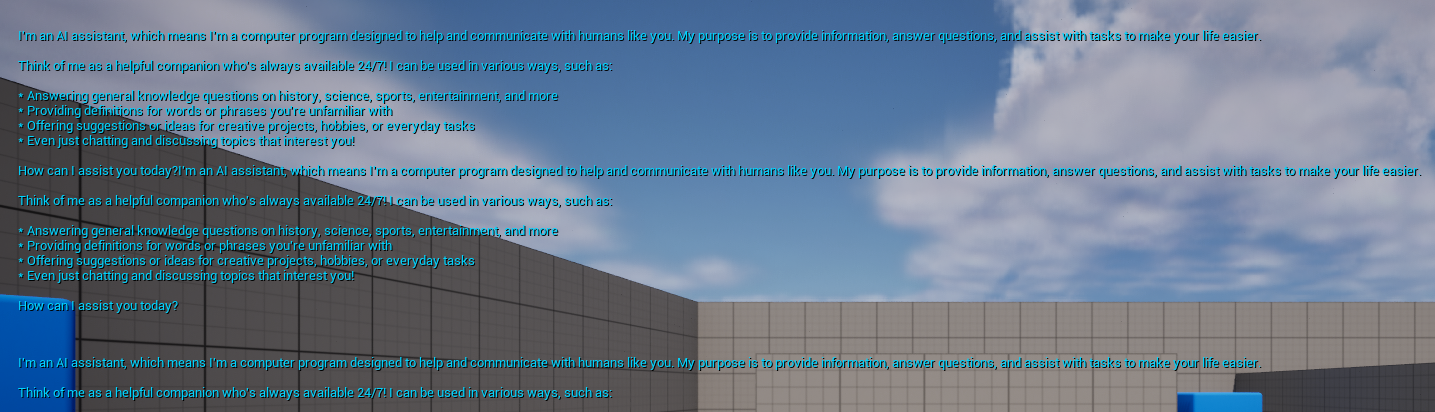

连接 "Ollama Request" 节点 和 "Messages" 相关节点,点击运行,即可看到屏幕上打印 Ollama 返回的聊天信息。如图

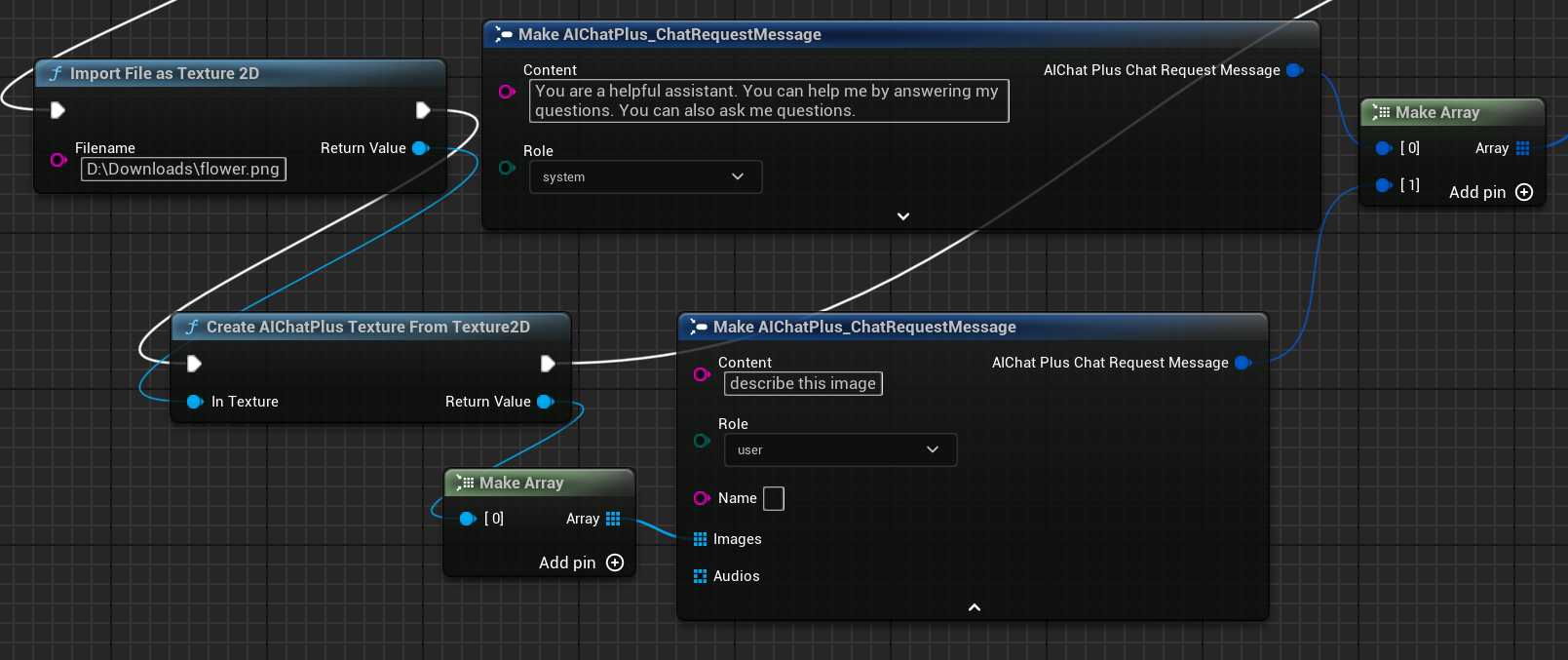

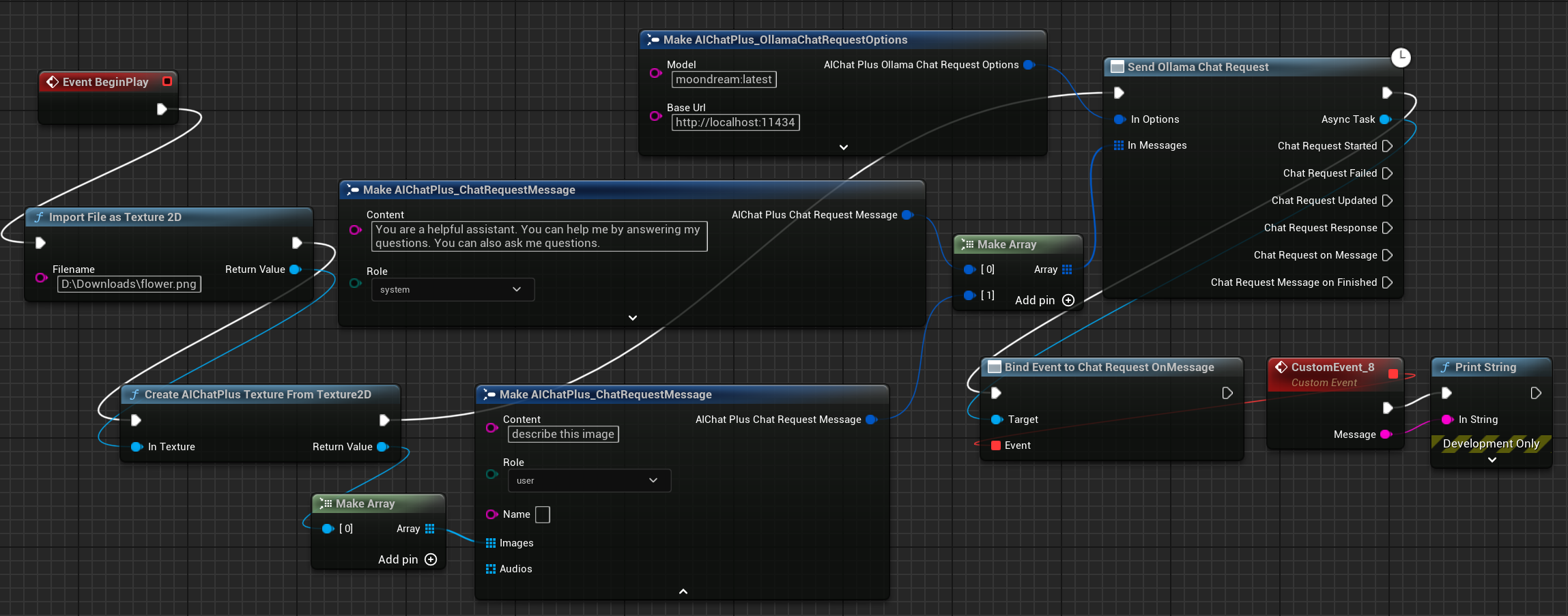

图片生成文字 llava

Ollama 同样支持了 llava 库,提供了 Vision 的能力

首先获取 Multimodal 模型文件:

设置 "Options" 节点,"Model" 设置为 moondream:latest

读取图片 flower.png,并设置 Message

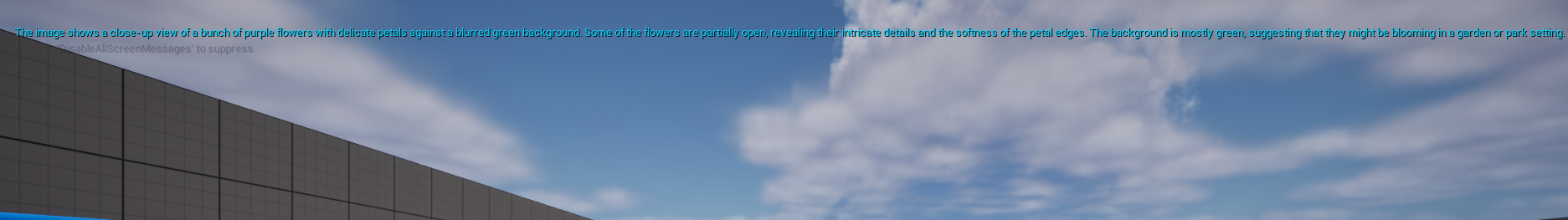

连接 "Ollama Request" 节点,点击运行,即可看到屏幕上打印 Ollama 返回的聊天信息。如图

原文地址:https://wiki.disenone.site

本篇文章受 CC BY-NC-SA 4.0 协议保护,转载请注明出处。

Visitors. Total Visits. Page Visits.